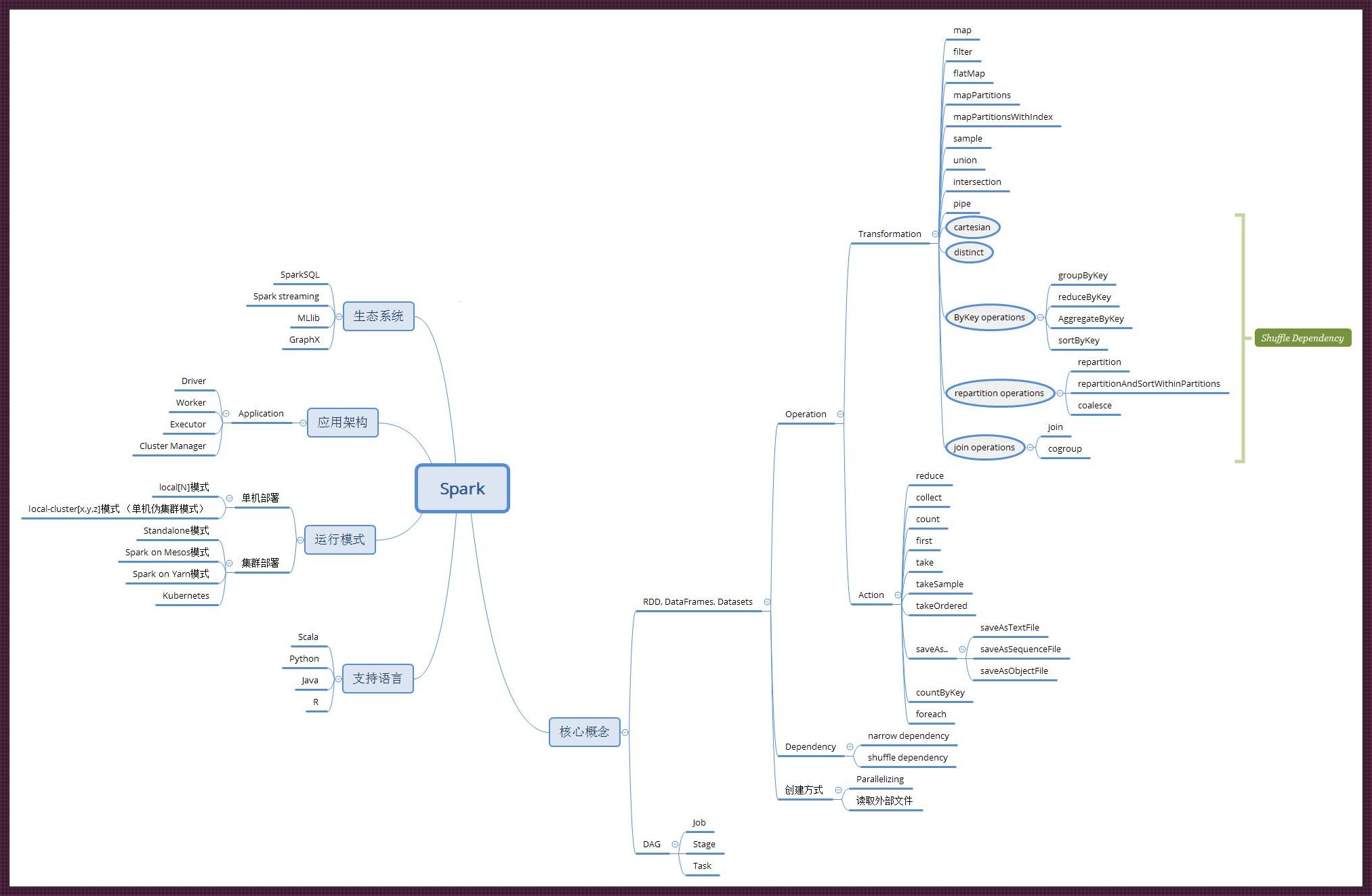

说实在的,要在这大数据的江湖里混,不得有几手绝活?今天,咱就来聊聊Spark这小家伙的强制类型转换。别小看了这货,它能让你数据处理的效率翻上几番,也能让你一头撞在南墙上。 哼,我可是有备而来,咱们的讨论可不能只是泛泛之谈。来吧,让那些自以为是的“数据侠”们见识一下,啥叫深度!

说Spark的类型转换,那真是“戏法人人会变,各有巧妙不同”。一不留神,你的Long就变成了Int,小数点后几位直接人间蒸发。这可不是闹着玩儿的,简直是“偷天换日”啊! “魔术”发生在那一刹那,你盯着屏幕,嘴里嘟囔着:“给我转!”,它就真的“Duang”地一声,变了。这过程中,你若是不小心,就成了“数字游戏”里的牺牲品。

你有没有遇到过这种情况?你盯着代码,眼睛都看花了,可就是不知道那个类型到底转成了啥。是Spark的“障眼法”太厉害,还是你被这类型转换的“迷雾”遮住了双眼? 别急,稳住。这时候,你得像侦探一样,逐行代码审查,找到那个“幕后黑手”。别忘了,在Spark这档事儿上,你可是福尔摩斯!

有时候,你可能会惊奇地发现,你的数据里竟然“无中生有”出了一个新的类型。这是Spark给你玩儿的“惊喜”吗? 非也,非也。这不过是你在类型转换的路上,又一“诡异”的收获。你得小心翼翼地处理这个“新生儿”,不然它会让你痛不欲生。

说来说去,还不是自己“技艺不精”,才会被Spark这小妖精给“戏弄”?但谁让咱们是数据处理的“勇士”呢?即使被Spark的强制类型转换弄得团团转,也要咬紧牙关,迎难而上。

别光顾着自嘲,干货来了。要想在Spark的类型转换中“游刃有余”,你得记住以下几点:

Spark的强制类型转换,犹如一把双刃剑。用得好,它能让你的数据处理工作如虎添翼;用不好,它会让你陷入无尽的痛苦。 但愿你在Spark的江湖里,能驾驭这把剑,成为那个“笑傲江湖”的数据侠!至于我,哼,不过是这个领域的“小丑”,自嘲一番,博君一笑。咱们下次再见!

2024-10-01 11:24:21 #科技信息

2024-08-16 23:59:49 #科技信息

2024-10-01 23:30:29 #科技信息

“亚洲皮”vs“欧美霜”:战火升级,网友争辩“谁”更懂肌肤?

2024-09-12 16:04:50 #创新科技

2024-08-31 13:39:55 #创新科技

2024-10-04 04:24:26 #前沿科技

2024-09-15 01:44:11 #其它资讯

2024-09-01 02:47:28 #其它资讯

2024-09-22 08:17:24 #创新科技

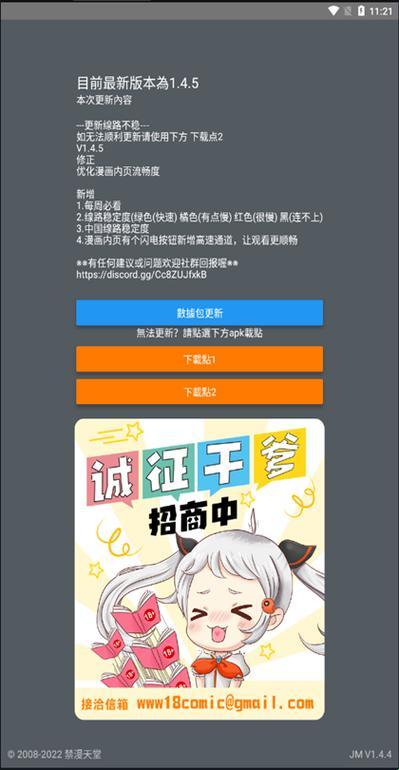

JMComic.Mic网页版入口iOS:所谓突破性创新,不过是一场自嗨的狂欢

2024-10-07 18:55:22 #其它资讯